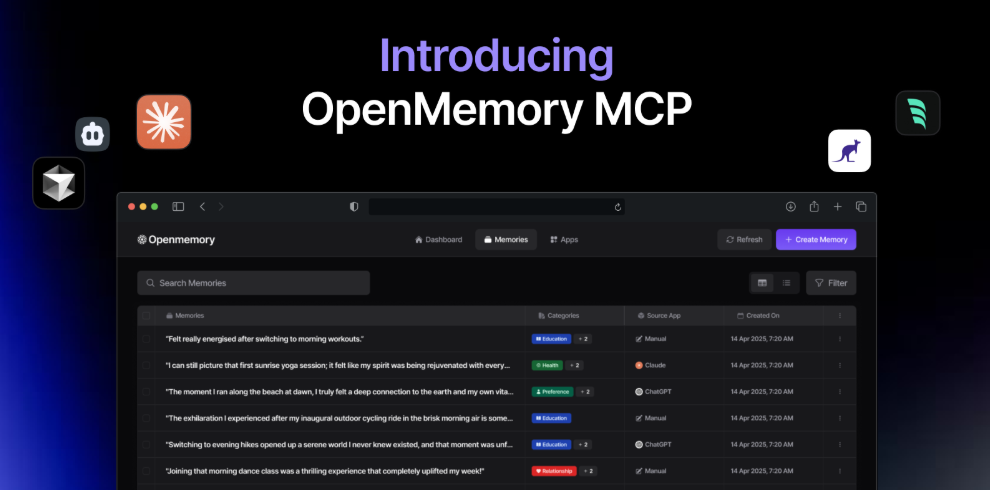

OpenMemory MCP

存儲具有OpenMemory MCP AI模型的私人記憶 - 確保,便攜式和開源。非常適合開發人員和隱私意識的用戶。

OpenMemory 是一個開放源代碼的個人記憶層,為大型語言模型(LLMs)提供私密、可攜帶的記憶管理。它確保用戶對自己的數據擁有完全的控制權,能夠在構建AI 應用程序時保持數據的安全性。此項目支持Docker、Python 和Node.js,適合開發者進行個性化的AI 體驗。 OpenMemory 尤其適合希望在不洩露個人信息的情況下使用AI 的用戶。

需求人群:

"該產品適合開發者、AI 研究人員以及對個性化AI 體驗感興趣的普通用戶。通過本地記憶管理,用戶可以安全地構建和使用AI 應用,避免隱私洩露的問題。"

使用場景示例:

開發個性化的聊天機器人,能夠記住用戶的偏好。

構建基於AI 的教育應用,根據學生的學習歷史調整內容。

使用AI 助手來管理日常任務,並根據過去的記憶提供建議。

產品特色:

私有數據管理:用戶的記憶數據存儲在本地,確保安全性和隱私。

個性化體驗:通過存儲個人化記憶,AI 應用能夠更好地適應用戶需求。

開源項目:用戶和開發者可以自由地查看、修改和擴展代碼。

易於使用的接口:提供簡潔的API 和前端界面,方便開發者集成。

社區驅動:鼓勵用戶反饋和貢獻,持續改進和擴展功能。

使用教程:

確保你的設備上安裝了Docker 和Docker Compose。

下載OpenMemory 項目源代碼。

在終端中運行命令' make build ' 以構建服務器和用戶界面。

運行命令' make up ' 啟動OpenMemory MCP服務器和UI。

訪問http://localhost:8765 查看API 文檔,或http://localhost:3000 使用用戶界面。